Głównym celem nieustannego rozwoju algorytmów Google jest udoskonalanie wyników wyszukiwania tak, aby dostarczały wartościowych informacji zgodnych z intencjami użytkowników. Współcześni internauci chcą otrzymywać kompleksowe odpowiedzi w jak najkrótszym czasie. Jakie wymagania pojawiły się przed twórcami i pozycjonerami stron internetowych w ostatniej dekadzie?

Czym jest algorytm Google?

Systemy rankingowe tworzące SERP-y (Search Engine Results Page), czyli wyniki wyświetlane w odpowiedzi na słowo kluczowe, wykorzystują nie jeden, ale wiele algorytmów wyszukiwania. To zautomatyzowane systemy, bazujące na zbiorach skomplikowanych reguł. Umożliwiają m.in.:

- porządkowanie zasobów internetowych,

- analizowanie zapytań użytkowników,

- ocenę stron pod kątem przydatności dla internautów.

Aby użytkownik wyszukiwarki otrzymywał trafne i wartościowe odpowiedzi w jak najkrótszym czasie, algorytmy analizują zarówno strony internetowe, jak i intencje stojące za pytaniem wpisanym w pole wyszukiwania. Google selekcjonuje miliardy witryn, zwracając uwagę na ich jakość techniczną, merytoryczną czy językową. Dzięki znajomości części czynników rankingowych możemy wykonywać audyty SEO i optymalizować strony internetowe tak, aby algorytmy oceniały je jako przydatne i lepsze od konkurencyjnych.

Nieustanny rozwój sieci i odbiorcy oczekujący maksymalnej wygody w uzyskiwaniu informacji wymuszają aktualizowanie algorytmów wyszukiwania. Google stara się dostarczać pożądane dane w przystępnej formie, nie narażając użytkowników ani na stratę czasu, ani na obcowanie z bezwartościowymi treściami.

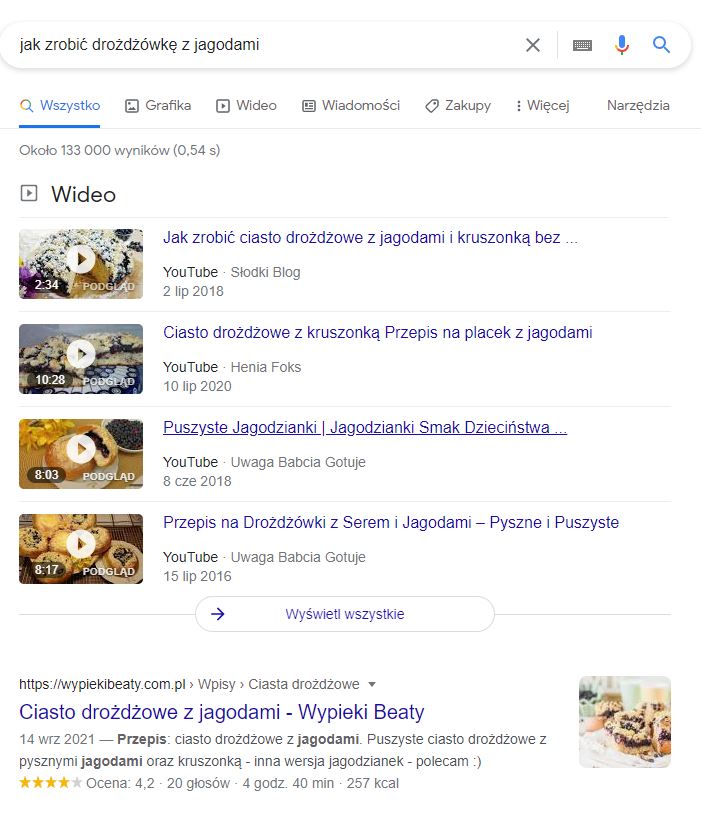

Dzisiejsza lista wyników wyszukiwania odbiega od zwyczajnej listy linków – rodzaj zapytania wpływa na wyświetlanie m.in. fragmentów z odpowiedzią, mapek czy grafów wiedzy. Celem tych elementów jest dostarczanie satysfakcjonujących odpowiedzi odbiorcy – bez konieczności odwiedzania witryn. Pozycjonerzy zajmują się nie tylko optymalizacją stron internetowych, ale także video SEO, które zwiększa szanse na wyświetlanie filmów w SERP-ach.

Każda kolejna aktualizacja algorytmu sprzyja udoskonaleniu wyników wyszukiwania dla użytkownika. Niestety za współczesnymi trendami kryje się historia nieetycznych manipulacji, stawiających na pierwszym miejscu roboty Google zamiast ludzi.

Początki działań SEO w Google

Dawne praktyki pozycjonerskie, które skutecznie zwiększały widoczność stron internetowych, dzisiaj mogłyby spowodować znaczące obniżenie ich pozycji, a nawet doprowadzić do zastosowania filtra ręcznego lub automatycznego.

Takie niepożądane praktyki wpisują się w kategorię Black Hat SEO. Zalicza się do niej m.in. ukrywanie treści i linków na stronie, nadmierne lokowanie słów kluczowych czy stosowanie spamerskich linków. Black Hat SEO, które można nazwać nieczystymi zagrywkami, jest totalnym przeciwieństwem White Hat SEO, czyli działań pozycjonerskich uwzględniających dostarczanie użytkownikom wartościowego contentu zgodnie z wytycznymi wyszukiwarki.

Kiedy Google zauważyło, że potężna liczba stron internetowych nie dostarcza odbiorcom pożądanych informacji w atrakcyjnej formie – zarówno tekstowej, jak i wizualnej – zapoczątkowało aktualizowanie algorytmów, które stawały się coraz bardziej wymagające. I coraz inteligentniejsze.

Najważniejsze aktualizacje algorytmu Google

O ile Google informuje o największych aktualizacjach algorytmu z dużym wyprzedzeniem, o tyle nie ujawnia wszystkich wdrażanych zmian. Liczby mówią za siebie – przeprowadzenie 464 065 eksperymentów doprowadziło do wdrożenia aż 3620 usprawnień w 2019 roku.

Chociaż nie znamy szczegółów wszystkich modyfikacji, specjaliści zajmujący się pozycjonowaniem stron internetowych muszą śledzić newsy branżowe i mieć najważniejsze aktualizacje algorytmów Google w małym palcu.

1998 – PageRank

Algorytm PageRank funkcjonował od 1998 roku. Został całkowicie wycofany w 2016 roku, ale już wcześniej zaprzestano jego aktualizacji. Prosta zasada oceniająca wartość strony internetowej na podstawie liczby linków przychodzących (backlinków) z różnych źródeł sprzyjała licznym manipulacjom w procesie linkbuildingu. PageRank określał wartość strony w skali od 0 do 10 – ocena była dostępna zarówno w Google ToolBar, jak i Google Search Console (ówczesnym Google Webmaster Tools).

Chociaż John Mueller przyznał, że Google wciąż używa PageRank wewnętrznie, istnieje znacznie więcej silniejszych algorytmów, a współczesny wskaźnik nie jest tożsamy z mechanizmem powstałym w latach 90. XX wieku.

2011 – Panda

Pierwszy zwierzak w Google wywołał poruszenie wśród pozycjonerów lekceważących wartość tekstów. Aktualizacja była wymierzona w witryny cechujące się niską jakością treści. Celem było obniżenie pozycji stron wypełnionych tekstami generowanymi automatycznie, wprowadzającymi w błąd i zduplikowanymi (powielonymi z innych witryn lub w obrębie jednej witryny). Panda uderzyła w keyword stuffing, czyli nadmierne upychanie fraz kluczowych w tekstach, które brzmi nienaturalnie i zniechęca użytkownika do zapoznania się z treściami.

2012 – Pingwin

Algorytm Pingwin ocenia profil linków przychodzących pod kątem naturalności. Co może wzbudzić niepokój Pingwina? Przede wszystkim gwałtowny przyrost backlinków, a szczególnie prowadzących z niespokrewnionych tematycznie i słabych jakościowo stron.

Pingwin analizuje także zróżnicowanie anchorów (treści linków). Linkowanie na anchory exact match, czyli tożsame ze słowem kluczowym (np. „pozycjonowanie stron”), powinny być przeplatane anchorami partial match (np. „przeczytaj o pozycjonowaniu stron”), zero match (np. „przeczytaj więcej”) i brandowymi (np. „Netim”).

2013 – Koliber

Algorytm Koliber zapoczątkował gruntowne zmiany w podejściu do słów kluczowych w SEO.

Przez wiele lat traktowano je przede wszystkim jako wyrazy, które należy umieszczać na stronach internetowych, aby algorytmy wyszukiwania wykryły związek między treścią a hasłem wpisanym w wyszukiwarkę. Łatwo się domyślić, że wartość merytoryczna, oryginalne sformułowania i poprawność językowa nie odgrywały głównych ról.

Aktualizacja sprawiła, że zaczęto przywiązywać coraz większą uwagę do intencji użytkownika stojących za słowami kluczowymi. Twórcy treści musieli się skupiać na kompleksowym opracowywaniu zagadnień i pisaniu dla ludzi – nie dla robotów. Nowy algorytm wymusił projektowanie treści przydatnych dla potencjalnych klientów firm i rzetelne odpowiadanie na pytania – szczególnie na słowa kluczowe z długiego ogona, czyli zawierające co najmniej kilka wyrazów. Kolibrowi zawdzięczamy popularyzację content marketingu bazującego na wartościowych i unikalnych treściach dla użytkowników.

2014 – Gołąb

Dzięki Gołębiowi możemy błyskawicznie znaleźć najbliższą restaurację, szewca czy fryzjera – bez wpisywania nazwy miasta. Algorytm umożliwił dopasowywanie wyników wyszukiwania do lokalizacji użytkownika, co oznacza, że krakowiak, poznaniak i wrocławianin otrzymają inne wyniki po wpisaniu np. „pizzeria” w Google.

2015 – Mobilegeddon

Mobilegeddon to potoczna nazwa dla aktualizacji algorytmu Mobile Friendly Update, która miała wywrócić wyniki wyszukiwania do góry nogami. O ile nie wywołała gwałtownej rewolucji, o tyle zapoczątkowała zmiany w kierunku dostosowywania stron internetowych do przeglądania na urządzeniach mobilnych. Dzisiaj trudno wyobrazić sobie efektywne prowadzenie biznesu online bez responsywnego sklepu.

2015 – RankBrain

Ogłoszenie RankBrain oznaczało wprowadzenie sztucznej inteligencji do algorytmu Google. Można powiedzieć, że ten system uczenia maszynowego dodał skrzydeł Kolibrowi. RankBrain analizuje słowa kluczowe pod kątem intencji użytkownika, skupiając się szczególnie na skomplikowanych zapytaniach. Porównuje frazy i szuka powiązań między poszczególnymi słowami, chcąc udzielić jak najtrafniejszej odpowiedzi.

Google podaje, że ok. 15% słów kluczowych dziennie jest wpisywanych po raz pierwszy do wyszukiwarki. To oznacza, że algorytm wyszukiwania nieustannie poznaje nowe frazy, co sprzyja coraz lepszemu interpretowaniu związków między wyrazami.

2019 – BERT

BERT (Bidirectional Encoder Representations from Transformers) to kolejna aktualizacja algorytmu w celu lepszego dopasowania wyników wyszukiwania do intencji użytkowników.

Google zaczęło wykorzystywać technologię przetwarzania języka naturalnego – BERT bazuje na sieciach neuronowych. O ile Koliber i RankBrain udoskonaliły analizę słów kluczowych z długiego ogona, o tyle BERT sprawdza się jeszcze lepiej w analizie zapytań, które nie mają charakteru hasłowego. W efekcie komunikacja z wyszukiwarką może przypominać coraz bardziej komunikację z drugim człowiekiem, zwłaszcza w dobie rosnącej popularności wyszukiwań głosowych, cechujących się rozbudowanymi konstrukcjami.

2021 – Mobile-First Index

Od marca 2021 roku roboty Google indeksujące strony internetowe traktują priorytetowo ich mobilne wersje. To oznacza, że każda witryna, której zależy na wysokich pozycjach w wynikach wyszukiwania, powinna być dostosowana do przeglądania na smartfonach.

Oczywiście wdrożenie Mobile-First Index nie powoduje całkowitego zignorowania stron typowo desktopowych w systemie rankingowym, ale nieresponsywne witryny mogą być oceniane jako słabsze jakościowo.

Ponadto pamiętajmy, że nieprawidłowe wyświetlanie strony na ekranie urządzenia mobilnego skutkuje niepożądanym zwiększeniem współczynnika odrzuceń.

2021 – Core Web Vitals

Aktualizacja Core Web Vitals obejmuje 3 wskaźniki wpływające na skuteczność pozycjonowania sklepów internetowych oraz innych witryn.

- LCP (Largest Contentful Paint) – mierzy czas renderowania największego elementu strony, który jest wyświetlany w części powyżej linii zanurzenia, czyli bez konieczności scrollowania. Nie ma znaczenia, czy jest to obrazek, czyli blok tekstowy – powinien się wyświetlić w maksymalnie 2,5 s.

- FID (First Input Delay) – dotyczy czasu mierzonego od pierwszej interakcji użytkownika ze stroną (np. kliknięcia linka, rozwinięcia menu) do reakcji przeglądarki. Dobry FID powinien wynosić poniżej 100 ms. Uwaga – FID nie dotyczy scrollowania czy powiększania elementów witryny.

- CLS (Cumulative Layout Shift) – ocenia wizualną stabilność strony, czyli wykrywa niepożądane przesunięcia widocznych elementów. Akceptowalny wynik to poniżej 0,1.

Każdemu nowemu czynnikowi rankingowemu przyporządkowano 3-stopniową skalę.

Źródło: web.dev/vitals/

Czy to oznacza, że specjalista SEO może przymknąć oko na „pomarańczowe” wyniki?

Nie, ponieważ podobnie jak „czerwone” wyniki, mogą obniżyć pozycję strony w wynikach wyszukiwania. Najważniejsza jest ocena czy strona spełnia (lub nie spełnia) podstawowe wskaźniki internetowe. Serwis może być oceniony jako szybki, nawet jeżeli pojedyncze wyniki (laboratoryjne) są pomarańczowe lub czerwone.

Pamiętajmy, że ocena algorytmu Google nie powinna być jedynym motywatorem do ulepszeń. Wolne ładowanie się elementów i problematyczny layout pogarszają doświadczenia użytkownika witryny, co może uniemożliwić osiągnięcie satysfakcjonującej konwersji.

2021 – Link Spam Update

Aktualizacja Link Spam Update powstała w celu skuteczniejszej eliminacji spamowania linkami. Wdrożeniu nowej aktualizacji towarzyszyło przypomnienie o dobrych praktykach w oznaczaniu linków o charakterze komercyjnym: afiliacyjnych i sponsorowanych.

Wymienione aktualizacje algorytmów są najważniejszymi modyfikacjami wdrożonymi w ostatniej dekadzie. Ponieważ Google wprowadza setki usprawnień w każdym roku, a spora część pozostaje niesprecyzowana, nie sposób opisać wszystkich zmian w jednym artykule.

Ciągłe udoskonalanie algorytmów Google sprawia, że specjaliści SEO muszą być na bieżąco z branżowymi newsami. Aktualizowanie wiedzy jest niezbędne do planowania skutecznych strategii pozycjonowania stron. Jeżeli pozycjoner zignoruje kluczowe update’y, ułatwi konkurencyjnym witrynom zdobywanie wyższych pozycji w wynikach wyszukiwania.

Jeśli chcesz mieć pewność, że Twoja strona będzie dostosowana do najnowszych wymogów Google, a specjalista SEO nie przeoczy żadnej aktualizacji algorytmów, skontaktuj się z nami.

Naszą redakcję tworzą eksperci marketingu internetowego: specjaliści SEO, SEM/PPC, social media i copywriterzy. Chętnie dzielimy się wiedzą – jeśli masz do nas pytania, zostaw je w komentarzu. Z przyjemnością na nie odpowiemy 🙂